OpenAI revoluciona el mundo del audio con nuevos modelos de voz y transcripción

Son más potentes y eficientes

OpenAI ha dado un paso importante de cara al futuro al anunciar nuevos modelos de audio que incluyen capacidades de conversión de voz a texto y de texto a voz. Estas novedades permiten a los desarrolladores crear agentes más potentes, personalizables y expresivos que nunca antes. Otro paso más en la evolución de la inteligencia artificial.

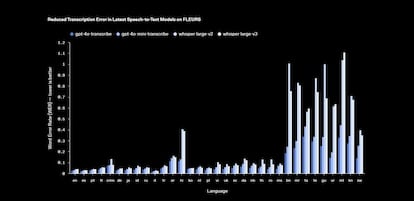

Los nuevos modelos de voz a texto de OpenAI, denominados gpt-4o-transcribe y gpt-4o-mini-transcribe, representan una mejora significativa en comparación con los modelos Whisper existentes. Los avances se centran en tres áreas clave: la reducción de la tasa de errores en la transcripción, el reconocimiento de idiomas y la precisión general. ¿Cómo lo han logrado? A través del uso de técnicas avanzadas de aprendizaje por refuerzo y un extenso entrenamiento con conjuntos de datos de audio diversos y de alta calidad.

Lo mejor que ofrecen los nuevos modelos de OpenAI

La compañía afirma que estos nuevos modelos de audio son capaces de comprender mejor los matices del habla, reducir los errores de reconocimiento y mejorar la fiabilidad de las transcripciones, incluso en situaciones complicadas. Esto incluye escenarios donde el audio presenta acentos difíciles, entornos ruidosos o variaciones en la velocidad del habla. En otras palabras, estos modelos están diseñados para funcionar en condiciones del mundo real, donde la perfección no siempre es posible.

Por otro lado, el modelo gpt-4o-mini-tts, que convierte texto a voz, ofrece una mayor capacidad de personalización. Los desarrolladores ahora pueden instruir al modelo sobre cómo articular el contenido del texto, lo que abre un abanico de posibilidades para crear experiencias de voz más naturales y adaptadas a las necesidades específicas de cada proyecto. Sin embargo, por el momento, este trabajo está limitado a voces artificiales preestablecidas, lo que podría cambiar en el futuro.

La compañía siempre piensa en el futuro

El equipo de OpenAI ha compartido su visión para el futuro de estos modelos de audio: "Mirando hacia adelante, planeamos seguir invirtiendo en mejorar la inteligencia y precisión de nuestros modelos de audio, así como explorar formas de permitir que los desarrolladores utilicen sus propias voces personalizadas. Esto permitirá crear experiencias aún más personalizadas, siempre alineadas con nuestros estándares de seguridad“.

Esta declaración sugiere que OpenAI no solo busca mejorar la tecnología existente, sino también ampliar todas las posibilidades de personalización, lo que podría incluir la integración de voces personalizadas en un futuro no muy lejano (siendo esto, en el caso de darse, un salto muy importante de cara al futuro de la compañía y los desarrolladores)

Disponibilidad y aplicaciones prácticas

Los nuevos modelos de audio ya están disponibles para todos los desarrolladores a través de las APIs de OpenAI. Además, la compañía ha anunciado una integración con el SDK de Agents, lo que facilita la creación de agentes de voz de manera rápida y eficiente. Para aquellos que buscan experiencias de voz a voz con baja latencia, OpenAI recomienda utilizar la API en tiempo real.

Parece bastante claro que estas herramientas son útiles para aplicaciones de asistencia virtual o chatbots, a la vez que para bastante claro que tienen un gran potencial en sectores como la educación, la atención al cliente, la accesibilidad y el entretenimiento. Imagina, por ejemplo, un sistema de transcripción en tiempo real durante una conferencia, o un audiolibro narrado con una voz que se adapta perfectamente al tono y estilo del texto. Las posibilidades son prácticamente infinitas y, además, con una excelente eficiencia en el nuevo modelo de OpenAI.