¿Las advertencias de Oppenheimer sobre las armas atómicas se podrían aplicar a la IA?

Más que de las implicaciones globales de una tecnología, las democracias deben preocuparse antes de lo que traería que sus rivales la desarrollasen mientras ellas rechazan hacerlo por motivos éticos

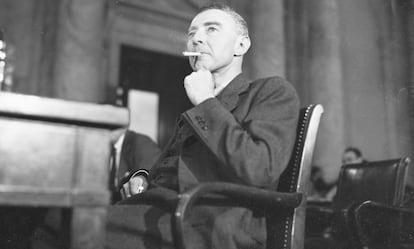

Robert Oppenheimer es un nombre muy conocido en Estados Unidos gracias a su trabajo de investigación con las armas atómicas. Una tecnología que ayudó a salvar el mundo en la segunda guerra mundial y que, a la vez, lo ha mantenido aterrorizado desde entonces. Su reputación de brillante científico atormentado por los dilemas de la era nuclear está experimentando todo un renacimiento de la mano de Hollywood. Su historia no es solo un reflejo de la lucha del científico consigo mismo, sino que contiene una importante lección sobre cómo las sociedades democráticas deberían lidiar con otra tecnología que tiene visos de cambiarlo todo: la inteligencia artificial. Por desgracia, corremos el riesgo de no haber aprendido bien la lección.

Oppenheimer y sus colegas científicos crearon la bomba atómica porque casi nada hubiera sido peor que una victoria del Eje en la segunda guerra mundial. Con todo, en 1950, el padre de la bomba atómica se opuso a la construcción de la bomba de hidrógeno —mucho más potente que cualquier otra versión hecha antes— porque consideró que las herramientas que se estaban usando en la guerra fría tenían el potencial de ser más peligrosas por sí mismas que cualquier enemigo de Estados Unidos. “Para ser honesto”, predijo, “lo más probable que suceda en un futuro es que haya una guerra, exploten las bombas atómicas y con ellas llegue la muerte y el final de toda la libertad”.

Oppenheimer perdió el debate sobre la bomba H, lo que le costó que su lealtad fuera puesta en entredicho y que sus permisos de seguridad fueran retirados. Referencia aparte, los paralelismos entre el desarrollo de las bombas atómicas y el de la IA son obvios.

La rápida innovación en el campo de la inteligencia artificial está espoleando otra revolución tecnológica. Una vez más, los mejores científicos, ingenieros y emprendedores discuten sobre si, sencillamente, es demasiado peligroso liberar una tecnología como esta en un mundo tan enfrentado como el nuestro. En marzo, científicos de primer nivel y expertos en tecnología hicieron un llamamiento a frenar de forma temporal el desarrollo de la IA. En mayo, cientos de expertos escribieron que la IA tiene el mismo riesgo de extinguirnos que una guerra nuclear. Geoffrey Hinton, un hombre tan prominente en lo que a IA se refiere como lo era Oppenheimer en física, dimitió de su puesto en Google para advertir del “riesgo existencial” que nos espera.

Estas preocupaciones de los expertos son realmente comprensibles. Dejando de lado la posibilidad de robots asesinos controlados por IA —al igual que la mayoría de las tecnologías— el mundo cambiará para mejor (por ejemplo, con asistencia médica de más calidad) y para peor (más desinformación, ayudar a los terroristas a construir armas químicas). Con todo, la solución que Oppenheimer propuso en su día, y que algunos de sus sucesores están proponiendo hoy, no son soluciones en absoluto.

Oppenheimer tenía toda la razón al decir que las bombas termonucleares eran terribles armas de destrucción de civilizaciones. Estaba equivocado al decir que lo mejor era simplemente no construirlas. Ahora sabemos que la Unión Soviética de Stalin ya había decidido crear su propia bomba de hidrógeno para cuando Washington estaba planteándose si hacerlo o no en 1950. Si Estados Unidos hubiera desechado el desarrollo de esa arma, tal y como admitió posteriormente el científico soviético Andrei Sakharov, Stalin hubiera maniobrado para “explotar la estupidez del adversario tan pronto como hubiera sido posible”.

Un mundo en el que los soviéticos hubieran tenido la más avanzada bomba termonuclear no hubiera sido un mundo mejor o más seguro. Moscú hubiera poseído una fantástica baza para llevar a cabo chantajes geopolíticos —justo lo que hizo el sucesor de Stalin, Nikita Khrushchev, a finales de los 50, cuando los soviéticos tomaron la delantera en misiles de largo alcance.

En el fondo, el Gobierno de Estados Unidos hizo caso al consejo de Oppenheimer, pero a su propia y limitada manera: negoció controles de armas que restringían el número y los tipos de cabezas nucleares en manos de las superpotencias, y las maneras en las que los países podían hacer pruebas con ellas. Estados Unidos consiguió los mayores éxitos en esta política de constricción mutua cuando dio muestras de que estaba dispuesto a evitar que la Unión Soviética alcanzara el monopolio nuclear.

Ahora Estados Unidos está de nuevo al principio de otro largo debate en el que su supremacía se entremezcla con consideraciones sobre el bien común. Es completamente posible que el mundo termine por necesitar un acuerdo multilateral para controlar el desarrollo de la IA o sus aplicaciones más peligrosas. Las autoridades de Estados Unidos tienen una cierta esperanza de que Moscú y Pekín tendrán el deseo de sentarse a regular una tecnología que tiene el potencial de ser tan disruptiva para sus sociedades como lo sería en el caso de sociedades democráticas.

Lo que no ha cambiado en absoluto entre la era atómica y la de la IA es que Estados Unidos no tiene ninguna intención de encontrarse en posición de debilidad porque el Ejército Popular chino haya desarrollado la siguiente revolución militar, o porque China y Rusia hayan ejecutado la mayor parte de los avances en IA —para controlar mejor a sus ciudadanos y expandir con más eficacia su influencia por el mundo— mientras las democracias se quedaban quietas.

“Las tecnologías relacionadas con la inteligencia artificial serán una enorme fuente de poder para las empresas y países que las desarrollen”, se lee en el informe emitido en 2021 por un panel de expertos encabezado por el antiguo consejero delegado de Google, Eric Schmidt, y el ex secretario de defensa, Robert Work. Al igual que sucedió en la era atómica, las democracias primero deben abordar el riesgo que representa para su supervivencia que sus rivales desarrollen de forma asimétrica las nuevas tecnologías. Luego, pueden preocuparse de los riesgos que esas tecnologías representan para todos.

Tal y como entendió el presidente que decidió construir la bomba de hidrógeno hace ya 70 años. “Nadie quiere usarla”, insistió Harry Truman. “Pero... Tenemos que tenerla, aunque sea, solo con fines de negociar con los rusos”. En esta era de dinamismo tecnológico e intensa rivalidad global, Estados Unidos necesita nuevos Oppenheimers —pero probablemente necesite más nuevos Harry Trumans.

Sigue toda la información de Cinco Días en Facebook, Twitter y Linkedin, o en nuestra newsletter Agenda de Cinco Días