ChatGPT no tiene límites: aprende a moderar el contenido de las redes sociales

OpenAI ha mostrado la efectividad que tiene el uso de esta IA

GPT-4, el potente modelo de lenguaje detrás de ChatGPT Plus, podría asumir pronto un nuevo rol como moderador de servicios en línea, supervisando foros y redes sociales en busca de contenido malicioso que no debería ver la luz del día. Así lo afirma una nueva entrada de blog de la compañía OpenAI. Esta señala que esto podría ofrecer "una visión más positiva del futuro de las plataformas digitales".

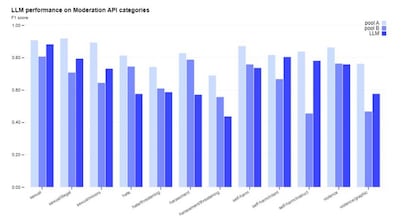

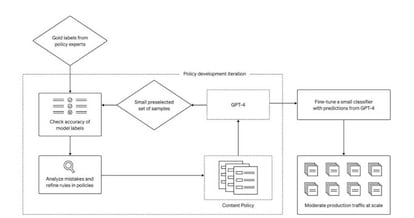

En lugar de moderadores humanos, OpenAI sostiene que al emplear la Inteligencia Artificial (IA) como GPT-4, se puede lograr "una iteración mucho más rápida en los cambios de políticas, reduciendo el ciclo de meses a horas". Además, "la IA también puede interpretar reglas y matices en la extensa documentación de políticas y adaptarse instantáneamente a las actualizaciones de políticas, lo que resulta en una etiquetación más consistente", afirma la firma desarrolladora.

Un uso de ChatGPT que, en principio, optimizaría el trabajo

Por ejemplo, el artículo de blog explica que los equipos de moderación podrían asignar etiquetas a contenido para indicar si cumple o no con las reglas de una determinada plataforma. Luego, GPT-4 podría tomar el mismo conjunto de datos y asignar sus propias etiquetas, sin conocer las respuestas de antemano. Es decir, que se aplicaría un aprendizaje que, eso sí, está por ver cómo interfiere en las relaciones que existen en las redes sociales.

Eso sí, los moderadores podrían comparar los dos conjuntos de etiquetas y utilizar cualquier discrepancia para reducir la confusión y agregar procesos más claros a sus reglas. En otras palabras, GPT-4 podría actuar como un usuario común y evaluar si las reglas tienen sentido. Lo cierto, es que parece increíble el nivel de notificación que ofrece la herramienta.

En la actualidad, la moderación de contenido la realizan seres humanos, lo que los expone regularmente a contenido potencialmente ilegal, violento o perjudicial. Hemos visto repetidamente el terrible impacto que puede tener la moderación de contenido en las personas, con Facebook pagando 52 millones de dólares a moderadores que sufrieron de trastorno de estrés postraumático debido a los efectos de su trabajo.

Reducir la carga sobre estos moderadores podría ayudar a mejorar sus condiciones de trabajo, y dado que las IA como GPT-4 son inmunes al tipo de estrés mental que sienten los humanos al manejar contenido problemático, podrían ser desplegadas sin preocuparse por el agotamiento y el trastorno de estrés postraumático.

Cosas que hacen pensar

Sin embargo, surge la pregunta de si utilizar la IA de esta manera resultaría en la pérdida de empleos, por poner un ejemplo. La moderación de contenido no siempre es un trabajo divertido, pero sigue siendo un trabajo… Y si GPT-4 reemplaza a los humanos en esta área, es probable que haya preocupación de que los actuales moderadores de contenido simplemente queden desempleados en lugar de ser reasignados a otras funciones.

OpenAI no menciona esta posibilidad en su entrada de blog, y realmente es algo que las plataformas de contenido deben decidir. Pero esto podría no disipar los temores de que las grandes empresas utilicen la IA simplemente como una medida de ahorro de costes, con poca preocupación por las consecuencias.

Aun así, si la IA puede reducir o eliminar los problemas de estrés a los que se enfrentan los equipos actuales y que, además, suelen ser poco apreciados a la hora de moderar el contenido en los sitios web utilizados por miles de millones de personas todos los días. Por lo tanto, si todo se hace con buen criterio con ChatGPT, el uso puede ser positivo.