Esta IA da miedo porque te hará decir lo que no quieres

El futuro de las deepfakes es cada vez más oscuro

Una de las primeras cosas que tenemos que decirle a un niño que se inicia en el uso de internet, las redes sociales o las nuevas tecnologías es que no se crea todo lo que le cuenten en el mundo virtual. Por desgracia, el problema llega cuando ni siquiera podemos fiarnos de lo que estamos viendo y creemos que es 100% real y fiable.

Algo así ocurre con una nueva aplicación de esa palabra que está de moda y que todos llaman "inteligencia artificial", IA para los amigos, que es capaz de modificar lo que alguien dice en un vídeo simplemente borrando las palabras que no queremos escuchar para poner otras en su lugar.

Esto ya es posible tras la unión de investigadores de la Universidad de Stanford, el Max Planck Institute for Informatics, la Universidad de Princeton y Adobe, que han creado una herramienta que han presentado bajo el nombre de "Text-based Editing of Talking-head Video". Es decir, algo así como "Editor de texto de vídeos de cabezas parlantes".

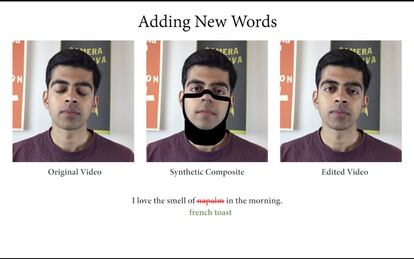

Básicamente esta IA lo que hace es analizar el vídeo fotograma a fotograma "escuchando" los fonemas, definiendo la posición y geometría de la cabeza (en 3D), los reflejos que tiene, su expresión y, por último, la iluminación general para, más tarde, adaptar todos esos datos al nuevo texto manteniendo la apariencia de quien habla.

Su uso no creáis que es muy complicado ya que, como podéis ver por el vídeo que tenéis justo encima, solo hay que cambiar las palabras que no queremos que alguien diga y sustituirlas por otras que nos gusten más. En uno de los muchos ejemplos que ofrecen, juegan con la famosa frase de Apocalipsis Now de "Me encanta el olor del Napalm por la mañana", que por arte de magia la convierten en "Me encanta el olor de las tostadas francesas por la mañana".

La ética, un problema real

Ni qué decir tiene que en un mundo donde es complicadísimo diferenciar entre informaciones y contenidos reales de otros que son falsos, añadir más leña al fuego con herramientas como esta es algo que da auténtico pavor. Sobre todo porque llevaría el listón de las deepfakes a un nivel difícil de detectar. Sus creadores son conocedores de ese riesgo y en el propio blog donde han publicado su trabajo hablan del miedo que les produce que todo su esfuerzo acabe en malas manos. Y no sin razón.

Sea como fuere, de momento hay una buena noticia. Y es que la herramienta todavía está en una fase de desarrollo temprano, con muy buenos resultados, pero lejos de lo que podemos esperar cuando ya esté al 100%. Ahora, "solo" es posible modificar lo que digan los bustos parlantes bajo unas condiciones muy concretas: se les debe ver muy bien la cara y el encuadre de los vídeos está muy limitado a los que podemos ver en el ejemplo de YouTube que tenéis más arriba.

Lo dicho, da miedo.