El auge de la IA es infraestructura disfrazada de ‘software’

Las tecnológicas que controlan los centros de datos y el suministro energético pueden tener ventaja

¿Son las startups de inteligencia artificial como las empresas de software? Desde que el chatbot ChatGPT de OpenAI hizo su debut viral a finales de 2022, los inversores han tratado la nueva tecnología como si compartiera las mismas características financieras que los anteriores proveedores de código informático: bajos costes marginales y potencial para una gran escala. Esta creencia ha contribuido a impulsar la valoración de OpenAI hasta los 300.000 millones de dólares, mientras que su rival Anthropic busca alcanzar los 100.000 millones. La apuesta es que aquellas que capten usuarios desde el principio se consolidarán como la interfaz predeterminada para la IA, captando datos, distribución y poder de fijación de precios. Al fin y al cabo, así es como se establecieron gigantes del software como Microsoft, Salesforce y Oracle.

Esta analogía está empezando a resquebrajarse porque las empresas de IA tienen costes diferentes. Entrenar un modelo de lenguaje grande puede costar cientos de millones. Pero conseguir que el modelo genere respuestas en tiempo real, un proceso conocido como inferencia, es un gasto continuo. Cada consulta activa miles de chips, consumiendo energía y ancho de banda de comunicaciones. Esto se parece menos a un software y más a un servicio público: un negocio que consume mucha energía y requiere una gran infraestructura, cuyos costes dependen de la demanda.

Hay mucho en juego. Según McKinsey, satisfacer la demanda futura de servicios de inferencia en todo el mundo requerirá una inversión mínima de 3,7 billones en centros de datos centrados en la inteligencia artificial. Se prevé que ese gasto impulse la demanda incremental de electricidad hasta aproximadamente 733 teravatios-hora, la misma energía que se necesita para abastecer a 68 millones de hogares.

Para entender por qué, pensemos en cómo funcionan las consultas de IA. Los modelos de tamaño medio suelen ejecutarse en clústeres de dos a cuatro chips, mientras que las tareas más grandes pueden requerir hasta ocho. Generar una salida de un millón de tokens, un punto de referencia común para cargas de trabajo avanzadas, puede llevar entre 30 y 40 minutos en un clúster de 8 chips, lo que se traduce en unos 40 a 55 dólares en costes directos de computación cuando se utilizan los procesadores H100 de Nvidia. A diferencia del software tradicional, donde los costes marginales se acercan a cero, cada consulta de IA genera nuevos gastos. La energía agrava la carga. Un chip H100 consume alrededor de 700 vatios a plena carga y, a tarifas industriales, de 10 a 15 centavos por kilovatio-hora en EE UU, los costes se acumulan. Una empresa que procesa 10.000 millones de tokens al día podría enfrentarse a una factura anual de millones, y la refrigeración y las ineficiencias suelen duplicar esa carga.

Sin embargo, aunque los costes de cada consulta de IA se han mantenido estables, los ingresos por consulta están disminuyendo. Desde 2022, los precios de los tokens han caído, hasta 280 veces, según la Universidad Stanford. Los usuarios más importantes pueden negociar acuerdos por volumen, que reducen los precios estándar.

La guerra de precios es en gran medida estratégica. Los desarrolladores están recortando las tarifas para impulsar la adopción, hacerse con cuota de mercado y fidelizar a los usuarios. Pero esa carrera por hacerse con cuota de mercado se ha adelantado a la eficiencia y ha reducido los márgenes. Los proveedores que dependen del alquiler de capacidad de computación en la nube deben gestionar hábilmente esos costes, al tiempo que compiten con las grandes plataformas tecnológicas de las que dependen.

Esto explica por qué los gigantes tecnológicos compiten por controlar su propia infraestructura. La adquisición directa de energía, junto con el desarrollo interno de chips, ayuda a reducir los costes. Los gigantes de la computación en la nube, como Alphabet, propietario de Google, Microsoft y Amazon están asegurando el suministro de electricidad mediante acuerdos de compra de energía a largo plazo, al tiempo que aumentan sus inversiones en energía. Esto les permite obtener márgenes brutos de entre el 60 % y el 70 %.

Sin embargo, desarrolladores como OpenAI y Anthropic se enfrentan a una disyuntiva. Al vender directamente a las empresas, pueden cobrar precios que cubren totalmente el costoso procesamiento, lo que les permite obtener márgenes brutos similares. Pero el uso canalizado a través de socios en la nube a menudo resulta poco rentable. Los elevados descuentos por volumen de tokens dejan poco margen para el coste del alquiler de la infraestructura de IA. Cada nueva consulta se suma al dolor de cabeza.

Esa compensación ya está remodelando la estrategia de IA. Incluso Microsoft, que recibe ayuda del tráfico de OpenAI a través de su asociación, está invirtiendo capital en ampliar su propia huella de IA. A medida que los usuarios demandan resultados más largos y complejos, la carga de la infraestructura no hará más que aumentar. Por su parte, OpenAI está desarrollando su propio chip y construyendo centros de datos dedicados.

Los optimistas sostienen que una mejor ingeniería acabará solucionando este problema. Ya se han conseguido modelos más eficientes, utilizando matemáticas más sencillas, evitando cálculos repetidos al generar respuestas largas y procesando múltiples solicitudes de usuarios a la vez. Estos ajustes permiten que el mismo hardware gestione más solicitudes utilizando menos energía.

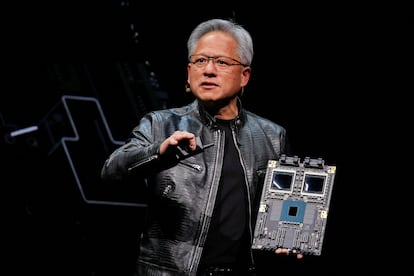

Los chips más nuevos prometen mayores avances. Se espera que los últimos procesadores Blackwell de Nvidia ofrezcan una eficiencia energética dos veces y media superior y un rendimiento de inferencia cuatro veces más rápido que el H100, según las presentaciones de la empresa. Sin embargo, las mejoras en el hardware también permiten modelos más complejos, lo que aumenta la demanda y anula cualquier avance.

Otros sostienen que los modelos de negocio se adaptarán. Con el tiempo, la industria podría desalentar a los usuarios de utilizar la IA para consultas de bajo valor, como escribir tuits o resumir páginas web, y dar prioridad a tareas de alto valor, como revisar código informático, por las que los clientes están dispuestos a pagar. Esto permitiría que los ingresos reflejaran mejor el coste de atender consultas complejas y de alta demanda.

Mientras tanto, OpenAI está tratando de ir más allá de la simple provisión de respuestas basadas en IA. Está a punto de lanzar un navegador web, está creando un sistema de pagos y ofrece consultoría empresarial. Estas iniciativas están diseñadas para generar ingresos a partir de otras actividades, al tiempo que integran a la empresa más profundamente en los flujos de trabajo de los usuarios.

Sin embargo, en este mundo, es probable que los ganadores sean aquellos que ya poseen toda la información. Amazon y Alphabet, con sus chips personalizados y contratos de energía, pueden contener los costes unitarios y reinvertir a gran escala en sus grandes negocios existentes. Por el contrario, las empresas que no controlan su propia infraestructura, como Anthropic, Perplexity e incluso OpenAI, se enfrentan a márgenes más estrechos y a una capacidad de negociación de precios limitada.

Incluso para los gigantes, la rentabilidad no está garantizada. Están gastando decenas de miles de millones de dólares en la apuesta de que existe un mercado profundo y duradero para las consultas de IA que generan más ingresos de lo que cuesta prestarlas. Desde los ferrocarriles hasta las telecomunicaciones, la historia está plagada de ejemplos de empresas que han fijado mal el precio de un nuevo servicio o han calculado mal la demanda del mismo. La IA puede llegar a ser omnipresente, pero la omnipresencia por sí sola no significa que los inversores que han pagado para construirla vayan a obtener un rendimiento.

Los autores son columnistas de Reuters Breakingviews. Las opiniones son suyas. La traducción, de Pierre Lomba, es responsabilidad de CincoDías.